分享文章

分享文章

国产大模型deepseek-R1本地部署手册

声明:该文章来自(大侠之运维)版权由原作者所有,K2OS渲染引擎提供网页加速服务。

近期deepseek多次冲上热搜,又是多模态支持,又是开源发布R1模型,最近还受到了网络攻击。

这篇文章介绍下如何快速部署deepseek-R1,本地访问,因为目前提供了最低7B数据集的模型。

部署方案:Ollama + DeepSeek-R1 + Anything-LLM

这个方案包括如何安装和配置 Ollama 进行模型管理,使用 DeepSeek-R1 进行推理,并通过 Anything-LLM 提供 Web 界面。

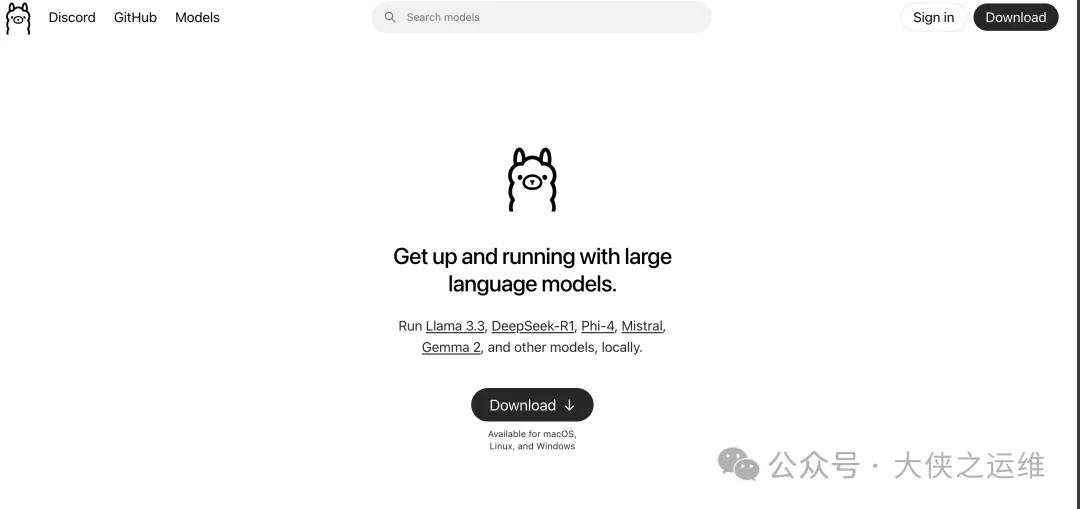

ollama安装

windows直接下载安装部署即可

访问地址:ollama.com

安装完成后,桌面右下角会有小图标。

模型下载

直接去搜索deepseek-r1模型,或者首页上点击。

然后在终端命令执行

ollama run deepseek-r1:7b

anything-llm安装

好的,以下是使用 Docker 安装 Anything-LLM 以及配置 DeepSeek-R1 模型的步骤。

1. 安装 Docker

首先,确保您的系统上已安装 Docker。如果尚未安装,可以参考以下链接进行安装:

docs.docker.com/docker-for-windows/install/

2. 克隆 Anything-LLM 仓库

在终端中执行以下命令来克隆 Anything-LLM 的 GitHub 仓库:

git clone https://github.com/anything-llm/anything-llm.git cd anything-llm

3. 创建 Dockerfile

在 anything-llm 目录下创建一个 Dockerfile,其内容如下:

# Use an official Python runtime as a parent image FROM python:3.9-slim # Set the working directory in the container WORKDIR /app # Copy the current directory contents into the container at /app COPY . /app # Install any needed packages specified in requirements.txt RUN pip install --no-cache-dir -r requirements.txt # Make port 8080 available to the world outside this container EXPOSE 8080 # Define environment variable ENV NAME Anything-LLM # Run app.py when the container launches CMD ["python", "app.py"]

4. 构建 Docker 镜像

在 anything-llm 目录下执行以下命令来构建 Docker 镜像:

docker build -t anything-llm .

5. 创建配置文件

在 anything-llm 目录下创建一个 config.yaml 文件,并添加 DeepSeek-R1 模型的配置:

model: name: deepseek-r1-7b path: /models/deepseek-r1-7b server: host: 0.0.0.0 port: 8080

将模型放置在指定目录下:

将下载的 DeepSeek-R1 7B 模型移动到 Docker 容器可以访问的路径,例如 /models/deepseek-r1-7b。

7. 运行 Docker 容器

使用以下命令运行 Docker 容器,并将模型目录挂载到容器中:

docker run -d -p 8080:8080 -v /path/to/models:/models --name anything-llm anything-llm

请将 /path/to/models 替换为您本地存放模型的路径。

8. 验证部署

通过浏览器访问 http://localhost:8080,您应该能够看到 Anything-LLM 的界面,并与 DeepSeek-R1 7B 模型进行交互。

总结

通过上述步骤,您可以使用 Docker 成功安装和部署 Anything-LLM,并配置 DeepSeek-R1 7B 模型。

[超站]友情链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

关注数据与安全,洞悉企业级服务市场:https://www.ijiandao.com/

- 1 习近平强调统筹好五对重要关系 7910427

- 2 男子上班3天被辞退 7天后公司没了 7971875

- 3 暴降20℃ 今年最复杂激烈天气来了 7849067

- 4 两会首场发布会 提到这些热点话题 7797298

- 5 首部票房破20亿美元亚洲电影 7645872

- 6 武汉樱花变“冰糖葫芦” 7570098

- 7 特朗普指责泽连斯基 中方表态 7473391

- 8 爸爸偷偷给22岁女儿买哪吒玩具 7303264

- 9 天塌了有高个顶着具象化了 7245326

- 10 多地解锁春日特色消费场景 7183038