分享文章

分享文章

DeepSeek V3开源模型 和OpenAI几亿烧出来的一样好

像是迷雾中走出的一头怪兽,DeepSeek V3 在先行“泄露”并引发一阵惊叹后,开发方深度求索正式发布了技术报告。

在这个报告中,Deepseek透露了训练的关键数据,其中最引人注目的,是它的高效和对算力资源依赖之小,同时效果又异常的好——

“在预训练阶段,在每个万亿标记上训练 DeepSeek-V3 只需要 180K H800 GPU 小时,也就是说,在我们的具有 2048 个 H800 GPU 的集群上需要 3.7 天。因此,我们的预训练阶段在不到两个月的时间内完成,成本为 2664K GPU 小时。结合 119K GPU 小时的上下文长度扩展和 5K GPU 小时的后训练,DeepSeek-V3 的完整训练成本仅为 2.788M GPU 小时。假设H800 GPU的租金为每GPU小时2美元,我们的总训练成本仅为557万美元。请注意,上述成本仅包括 DeepSeek-V3 的正式训练,不包括与架构、算法或数据相关的先前的研究或精简实验的成本。”

“我们对DeepSeek-V3 进行了全面的基准测试。尽管 DeepSeek-V3-Base 的训练成本较低,但综合评估表明,DeepSeek-V3-Base已经成为目前可用的最强大的开源基础模型,特别是在代码和数学方面。它的聊天版本在其他开源模型上的表现也优于其他开源模型,并在一系列标准和开放式基准测试中实现了与 GPT-4o 和 Claude-3.5-Sonnet 等领先闭源模型的性能相当。”

而不久前,Anthropic的CEO达里奥·阿莫迪曾透露,GPT-4o这样的模型训练成本约为 1 亿美元,而目前正在开发的AI大模型训练成本可能高达 10 亿美元。未来三年内,AI大模型的训练成本将上升至 100 亿美元甚至 1000 亿美元。

也就是,现在DeepSeek用 550 万美金 2000 张卡训出的开源模型,和OpenAI几亿烧出的模型一样好了。

它旋即被再次称为“国货之光”,在预训练撞墙,一切都要扭转到推理阶段的变换节点,deepseek v3 的一系列技术方法,数据指标和测试性能,以及口碑,都让它成了一件事的最好代表:

在“o1”时代,当算力不再是唯一因素,中国模型开发者的机会更多了。

“性能对标GPT-4o 以及 Claude-3.5-Sonnet”,而且是用开发者的嘴讲出

DeepSeek-V3 为幻方旗下的深度求索公司自研的MoE 模型,671B 参数,激活 37B,在 14.8T token 上进行了预训练。在Deepseek V3 技术报告公布的性能指标上来看,这个开源MoE模型,已经在性能上“对齐海外领军闭源模型”。

根据它的官方公告,它在多项评测成绩上,超越了 Qwen2.5-72B 和 Llama-3.1-405B 等其他开源模型,并在性能上和世界顶尖的闭源模型 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

Deepseek罗列了几个关键的表现领域:

百科知识:DeepSeek-V3 在知识类任务(MMLU, MMLU-Pro, GPQA, SimpleQA)上的水平相比前代 DeepSeek-V2.5 显著提升,接近当前表现最好的模型 Claude-3.5-Sonnet-1022。

长文本:在长文本测评中,DROP、FRAMES 和 LongBench v2 上,DeepSeek-V3 平均表现超越其他模型。

代码:DeepSeek-V3 在算法类代码场景(Codeforces),远远领先于市面上已有的全部非 o1 类模型;并在工程类代码场景(SWE-Bench Verified)逼近 Claude-3.5-Sonnet-1022。

数学:在美国数学竞赛(AIME 2024, MATH)和全国高中数学联赛(CNMO 2024)上,DeepSeek-V3 大幅超过了所有开源闭源模型。

中文能力:DeepSeek-V3 与 Qwen2.5-72B 在教育类测评 C-Eval 和代词消歧等评测集上表现相近,但在事实知识 C-SimpleQA 上更为领先。

这些打榜的行为已经是所有新模型的惯例操作,而因为这些官方数据是在模型悄悄在社区以及一些AI Infra平台上线后才跟着发布,反而让它“口碑先行”,在人们纷纷体验了它的媲美头部模型的能力后,这些数据让开发者社区印象更为深刻。

但V3 真正重要的意义不止在于开源再次逼近闭源,还在于它通过各种新的方法,不止在模型层卷,而是把整个模型的训练和推理当做一个系统来优化到了极致,并给出了诸多新的技术思路。

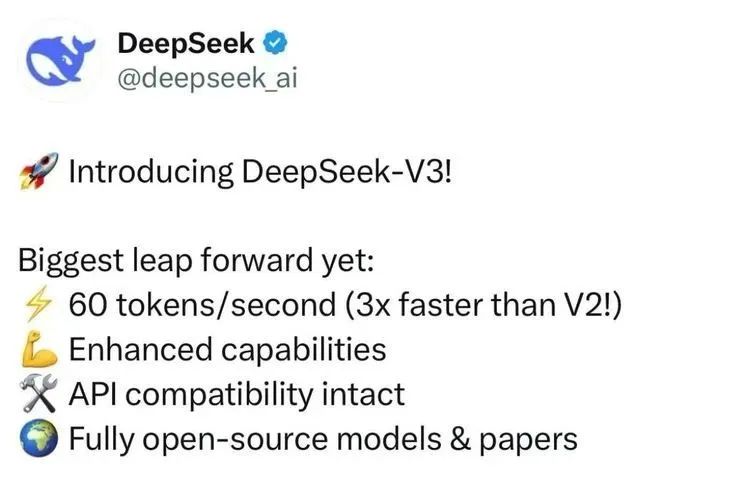

这一方面也体现在他的生成速度提升上,根据Deepseek官方,它的生成速度提升至 3 倍。

通过算法和工程上的创新,DeepSeek-V3 的生成吐字速度从 20 TPS 大幅提高至 60 TPS,相比 V2.5 模型实现了 3 倍的提升,为用户带来更加迅速流畅的使用体验。

想体验的可以登陆官网 chat.deepseek.com,它也支持 API 访问。而且,新版本将提供 45 天优惠价格体验期,直至 2025 年2 月8 日。

在技术报告和官方正式发布前,全球开发者就已经对这个来自东方的“圣诞礼物”欢呼了一阵。

能够做到“提前泄露”并引起一群自来水测试和把玩的国产模型并不多,无论它是否是Deepseek的某种策略,它确实证明了自己受关注和在开发者社区里的真实使用的程度。

根据Reddit上最早的“泄露”,它在基准测试LiveBench上评分都挤进了前列。整体性能超过了gemini 2 flash,以及Claude 3.5 Sonnet。

而随后,技术报告正式发布,开发者开始深挖它究竟做对了什么。

赞誉一片,“想快进到英伟达泡沫破裂”

简单来说,DeepSeek-V3 针对分布式推理做了创新的优化,进而显著提升了分布式MoE模型的负载分配效率,这不再只是从算法上,而是从整个系统上为未来更大规模的模型提供了新的可扩展性框架的可能。尤其在硬件资源有限的情况下,它最大化了效率。

在模型架构上,它和此前的V2 一样继续使用Deepseek自己一直相信和沿用的MLA+细颗粒度的MoE。简单说就是在注意力机制上做创新,对内存进行压缩,对MoE的运行机制进行创新的设计。

此外,几个亮点包括:

Deepseek V3 使用了辅助损失自由负载均衡策略(Auxiliary-Loss-Free Load Balancing)。

在混合专家模型(MoE)中,每个输入Token会分配给不同的“专家”进行计算。如果分配不均衡(某些专家负载过高),会导致效率降低和模型性能下降。传统方法通过增加一个额外的“辅助损失”来强制均衡负载,但这会对模型性能造成负面影响。DeepSeek通过动态调整专家的偏置值,使输入Token更均匀地分配给不同的专家,而无需引入额外损失。

这个方法有趣的地方是,通过监控每个专家的负载情况,在训练中动态调整每个专家的偏置,使得分配更公平。它避免了引入额外的优化目标,直接在负载均衡和模型性能之间找到了更优解。

另外,在MoE方面的冗余专家机制(Redundant Experts)也是这种追求平衡的思路。

在推理阶段,某些专家可能会因任务量过多而成为瓶颈。冗余专家机制通过为高负载专家创建“副本”,让这些任务分配到不同的副本上,缓解了计算压力并提升了整体推理速度。这种方法可以显著提升分布式推理的吞吐量,尤其是在高并发场景下,实现了资源的弹性扩展和更稳定的服务性能。

这些动作相当于是告诉那些调不好参数和平衡的人们:

我比你们更聪明。那些所谓的负载矛盾,我可以解决,并同时保持高水平的推理精度。

多Token预测目标(Multi-Token Prediction Objective, MTP)

传统语言模型一次只预测一个Token,训练信号较为稀疏,数据效率低。MTP让模型在每个输入Token的基础上同时预测多个未来Token,这样每次训练能提供更多的反馈信号,加速模型的学习。也就是,不是简单地并行预测多个Token,而是通过顺序预测保持每个Token间的因果链条。这样既提升了训练效率,也让模型在推理时能够更好地“规划”其输出。

对FP8 低精度训练的优化。

FP8 是一种极低精度的数据表示形式,比FP16 和BF16 的精度更低,但占用的内存和计算资源也更少。问题是FP8 的动态范围有限,容易出现数值溢出或不足。DeepSeek通过分块量化,将数据分成更小的组进行独立缩放,这样可以让模型更灵活地适应输入数据的变化范围,避免低精度带来的精度损失。

这种“分块量化+高精度累加”的策略就是先将数据分组,每组单独计算缩放因子,再通过高精度累加器进行累加计算。这种方法结合FP8 的低资源消耗和高精度运算,解决了传统低精度训练中的不稳定性问题。它大幅减少了训练所需的内存和计算成本,同时保持了与高精度训练相当的稳定性和性能。

除了模型方面,在训练设施上的创新也很关键,比如DualPipe流水线并行策略。

在分布式训练中,多个GPU需要同时处理大量数据,其中的通信开销是一个瓶颈。传统流水线方法很难做到完全的计算与通信重叠,造成资源浪费。DualPipe通过更精细的任务分解和调度,将计算和通信时间完全重叠,从而最大限度地利用了每一块GPU的性能。这个设计的核心是将数据分成小块,交替执行“计算”和“通信”任务。通过精确调整各任务的优先级和资源分配,让GPU在计算时也能同时处理通信操作,几乎完全消除了流水线中的“空闲时间”。除了提升效率,它值得玩味的地方更在于:

它显著降低了对硬件资源的需求。

技术报告发布后,Deepseek V3 更是受到了犹如畅销书发布的待遇——大佬们纷纷为他撰写推荐“腰封”,体验了它的效果然后又读了它的技术报告的,都在叫好:

推特上各个大佬纷纷点赞。

Meta的田渊栋也直接表示:

“DeepSeek这真是把H800 hack了底朝天[捂脸]太夸张了”

Andrej Kaparthy也再次赞扬Deepseek的技术报告值得一读。

另外一个有意思的地方是,今天最重要的一些AI Infra创业公司的创始人们也对Deepseek V3 充满好感。一个在推理侧再次推动着创新并由此可以刺激市场需求的模型,自然是推理侧的创业公司们需要和希望客户们看到的。

硅基流动的袁进辉在朋友圈点评:

“DeepSeek V3 训练仅用了 2000 张H800,算力成本 6 百万美元,给海外同行蛮大思想冲击,很多业内专家都点赞了,算力不是唯一决定因素,聪明的人加创新更让人敬佩。”

Lepton的创始人贾扬清则在朋友圈和X同时点评了V3 给他带来的思考。

•首先,现在我们正式进入了分布式推理的时代。一台单GPU机器(80*8=640G)的显存已经装不下参数了。新的大显存机器确实能容纳模型,但不管怎样,为了性能和未来扩展,分布式推理是不可避免的选择。

•即使在单个模型中,也需要关注 MoE 的负载均衡,因为每次推理只有大约5%的参数激活。目前还没仔细研究这部分的工作负载细节,但应该会很有趣。

•论文中特别提到引入“redundant expert”的概念,正是为了解决这个问题。这已经不是“一个模型多个副本”的问题,而是“每个模型子模块都有多个副本”,然后独立扩缩容。

•输入token的盈利模式已经很明确了。我个人推测,想让输出token变得盈利或至少收支平衡需要更多优化。不过如果我们相信“软件摩尔定律”(每 18 个月单token成本减半),这就不是问题。

• Tile或block级别的量化是必需的。这也和我们在 Lepton 的观察一致。我们还支持基于输入数据的动态量化(ahead-of-time dynamic quantization)。另外等硬件支持FP4 以后肯定还有不少可以玩的花样。

•冷知识:FP4 乘法实际上就是个16* 16 的table lookup…

•论文提到,在很多情况下,内存带宽是瓶颈。很期待看看即将推出的NVIDIA新硬件形态(比如NVL72)能如何提升分布式推理的性能和便捷性。

“Exciting years.” 他说。

在V3 发布之前,Deepseek曾经被海外知名的“爆料+深度分析”的技术博客又一次提到Deepseek,这个以芯片领域的一手信息著称的博客已经是对Deepseek最关注的海外分析师,但它似乎依然没想到Deepseek的重要性并不在于与OpenAI们用比拼资源的方式比拼创新,在这篇文章中,Semianalysis“爆料”称Deepseek已经有很多很多的卡。但在V3 发布后,它所指向的方向看来并不如此。

你依然需要万卡集群,但不是谁的卡多谁烧的钱多谁就理所应当会赢得一切了。

有网友甚至戏称:“想快进到Nvidia泡沫破裂的时刻”。

一切都在快速的展开。神话OpenAI们,尤其是以“卡”的名义神话然后看低中国开发者们自己的模型和Infra创新能力的阶段看起来要结束了。当然,前提是你不是只想“跟着喊几句”的创新,而是你真的做着

声明:本文来自于微信公众号硅星人Pro,作者:王兆洋,授权站长之家转载发布。

[超站]友情链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

关注数据与安全,洞悉企业级服务市场:https://www.ijiandao.com/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 两会上 总书记关心的那些事 7944795

- 2 雷军建议优化新能源车牌颜色 7969881

- 3 雷军回应不锈钢纸杯卖爆 7841671

- 4 向着中国式现代化奋力进发 7705457

- 5 美国返还41件中国文物艺术品 7603759

- 6 女生7号查出怀孕8号直接就生了 7528089

- 7 捏造80后死亡率5.2% 多人被处罚 7430027

- 8 #美暂停军援后乌克兰还能打多久# 7319797

- 9 AI三小时做的游戏9天赚了12万 7242680

- 10 中国制造进阶“升级版” 7143500

loliburin

loliburin